L’avatar IA : nouveau visage du contenu ? Zoom sur cette transition

+ Exemples d'utilisations de 4o sur l'image

Hello à tous,

Bienvenue dans cette 52ᵉ édition ! Cela fait un peu plus d’1 an que cette newsletter existe, on s’approche de la barre des 10 000 personnes, merci pour votre soutien 🙏

Vous pouvez cliquer sur le ❤️ au-dessus ou en fin de newsletter si vous appréciez le contenu, ça m’aide beaucoup !

Voici le sommaire de la semaine :

💼 La montée en puissance des avatars IA : quels usages business ?

🗞️ 3 actus importantes : A2A de Google, Midjourney v7 et Llama 4

⚡ 7 exemples d’utilisations de 4o sur la génération d’images

📝 Le vibe marketing : le no-code du marketing

⏳ Temps de lecture : 10 min

Me retrouver ailleurs :

🧑💻 Mes réseaux : Linkedin, Youtube

🤚 Rejoindre la communauté IA (ressources, échange, support, ..) : sur Circle

📞 Des besoins en IA ? Prendre RDV

📖 Se former sur l’IA : l’IA générative en entrepise ou automatisez votre création de contenu. (300€ de réduction via le code CONTENT_2025 jusqu’au 26 avril)

💼 La montée en puissance des avatars IA : quels usages business ?

Les avatars IA ou “quand l'IA commence à incarner le contenu, plutôt que de le produire.”

Depuis quelques mois, vous avez sûrement vu passer des visages qui parlent, qui bougent, qui vous regardent dans les yeux… sans jamais avoir été filmés. Ce ne sont pas des deepfakes. Ce sont des avatars IA, une nouvelle génération de contenu incarné par IA.

Un exemple avec une démo d’Argil.

L’idée est donc de faire un zoom sur cette transition en cours, ce qu’il est possible de faire aujourd’hui et les cas d’utilisations en entreprise.

Pourquoi c’est important ? On ne parle plus seulement de créer une vidéo ou une image… mais d'incarner un message, une identité, une marque, voire une stratégie de communication, sans caméra, sans tournage, sans équipe de production → une réduction de coût énorme avec la possibilité de scaler la distribution de contenu vidéo.

Et si c'était le début d'une révolution dans notre façon de créer (et consommer) du contenu ?

Comment générer un avatar IA ?

Créer un avatar IA, c’est plus simple qu’on ne l’imagine… Il existe une série d’outils clé en main à votre disposition. Pour des avatars fictifs ou humains.

De base, le process est simple :

une seule image de vous suffit

un audio pour la qualité de la voix

un prompt pour transposer cet avatar dans une situation particulière, même déclencher des expressions ou mouvements par un prompt.

Des outils comme Hedra, avec une version freemium, peuvent vous permettre de générer une 1ère base.

Voici le pitch de l’entreprise :

Et une utilisation de mon côté, avec la comparaison de mon enregistrement officiel (version IA sur fond noir, version réelle sur fond blanc)

Pour aller plus loin, des outils comme HeyGen, Synthesia ou Argil vous permettent d’améliorer la qualité de l’avatar. Souvent avec un enregistrement en haute définition (plutôt que capture d’écran), l’enregistrement de vos expressions, de vos gestes, etc

Côté voix, la meilleure solution pour l’instant est de passer par Eleven Labs et son système de voice cloning qui permet d’avoir le meilleur audio.

Mais comme vous l’observez sûrement, avoir une bonne vidéo est complexe puisqu’il y a une série d’éléments à prendre en compte.

Les conditions de succès pour un bon avatar IA

Avoir un visage qui parle n’est pas suffisant. Pour créer un avatar convaincant (et exploitable), plusieurs éléments doivent fonctionner ensemble :

1. La cohérence visuelle et expressive → avoir un visage expressif, en accord avec la voix et le ton du message. Un avatar qui dit "génial !" avec un visage neutre ou figé, casse immédiatement l’illusion. Les meilleurs modèles aujourd’hui (comme Hedra) parviennent à synchroniser micro-expressions, mouvements de tête et émotions contextuelles. Mais c’est encore loin d’être parfait…

2. Une voix bien choisie et bien clonée → L’impact émotionnel d’un message dépend énormément de la voix. Dans l’exemple plus haut, j’ai moi-même enregistré l’audio et ça change beaucoup de choses …

3. Un script adapté à un ton parlé → un script pour avatar IA doit être pensé à l’oral : phrases courtes, vocabulaire simple, rythme naturel.

4. Des mouvements naturels du corps et du décor → un avatar qui reste figé n’est pas exploitable. Le regard, les épaules, parfois même les mains doivent accompagner le discours.

Globalement, l’alignement voix/visage/corps et le décalage labial (lip-sync) sont les plus gros challenges.

Avoir un bon avatar IA, c’est donc une alchimie entre le texte, le son, le visuel, et le mouvement. Le moindre écart casse la magie.

Cas d’usage où les avatars IA sont déjà matures (et les limites)

Aujourd’hui, les cas les plus matures sont ceux qui s’appuient sur des formats courts, dynamiques et scénarisés. Quelques exemples :

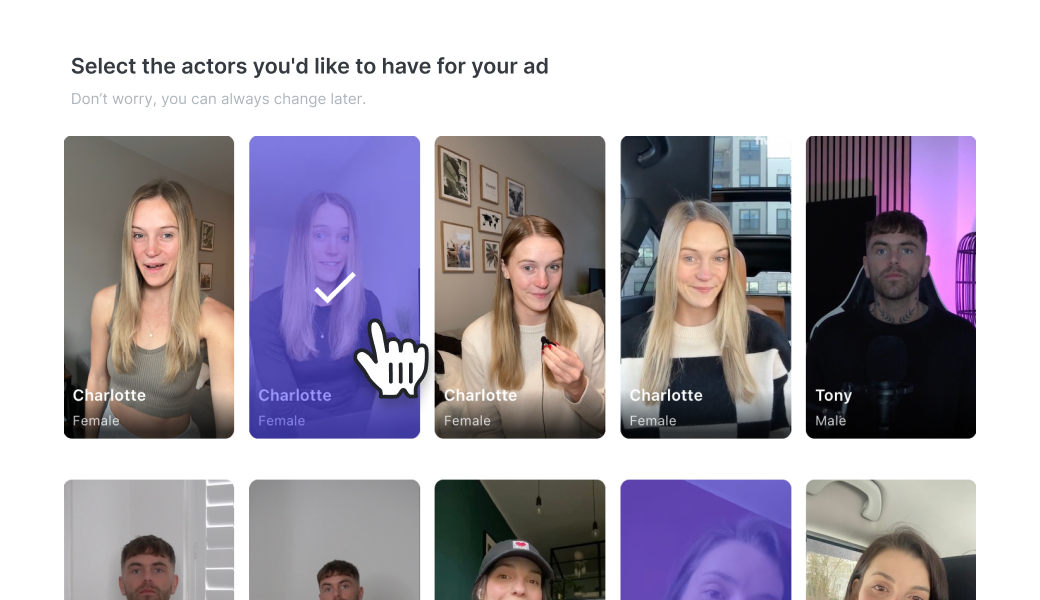

UGC / Vidéos produits en e-commerce

Des avatars IA présentent un produit, le tout enrichi de B-roll (séquences d’illustration) générés automatiquement.

Le meilleur outil sur le marché est Arcads.ai.

Vous pouvez sélectionner votre avatar qui a été enregistré par de vraies personnes ayant donné leur accord.

Et ajouter votre visuel ou produit. Cela permet de faire du contenu UGC scalable, pour un coût très faible. Une fois que les vidéos sont ajoutées en tant qu’ads, il suffit de laisser les algos identifiés quelles sont les ads qui performent le mieux.

Contenus pédagogiques / RH / formation interne

Avec un avatar IA, une entreprise peut produire des dizaines de vidéos explicatives multilingues sans mobiliser d’équipe. Beaucoup d’outils d’avatar IA sont utilisés dans ce cadre.

Vidéos "shorts" avec habillage automatique

Pour moi, c’est le cas d’utilisation le plus large et qui peut avoir le plus d’impact pour une entreprise : la création de contenu en format shorts avec son avatar IA.

L’idée est simple : utiliser les avatars comme un élément mineur de la vidéo (mais ajoutant un côté humain), puis enrichir le contenu avec du B-roll en utilisant Jupitrr par exemple. Enfin, le script est aussi généré par IA avec Eleven Labs.

À ce moment, tout réside dans la qualité du montage pour rentrer la vidéo impactante (et virale), avec animations de texte, des transitions et des cuts dynamiques.

➡️ C’est le format idéal pour alimenter une chaîne de contenu court avec une cadence quotidienne.

Un exemple concret avec ce post sur LinkedIn d’un profil avec plus de 500 000 followers (+500 likes sur le post). Comme on le voit, l’apparition de l’avatar reste très très mineur.

Les challenges encore présents

Sur les cas d’utilisations à venir et où les avatars sont encore limites, on retrouve les usages en temps réel (calls Zoom, avatars interactifs : trop de latence, manque d'expressivité, rendu pas toujours pro). Ou encore, les narrations longues ( documentaire ou storytelling avec beaucoup d’émotions).

Les fondations sont posées, mais les détails sont encore trop visibles. Ce sont justement ces détails qui font toute la crédibilité d’un avatar.

En bref

On est encore au tout début du potentiel des avatars IA.

Mais la qualité atteint déjà un niveau suffisant pour transformer radicalement notre manière de produire du contenu, surtout sur les formats courts.

Faire des shorts en quantité sans mobiliser du temps sur du tournage est une opportunité énorme pour beaucoup d’entreprises.

Dans les prochains mois, les cas d’usages vont s’élargir, les outils vont s’affiner, et les avatars deviendront plus naturels, plus expressifs… et plus omniprésents.

On est encore qu’au début….

🗞️ 3 actus importantes

Google lance A2A, un protocole pour faire collaborer tous les agents IA en entreprise

Google a lancé A2A (Agent-to-Agent), un nouveau protocole ouvert destiné à favoriser l’interopérabilité entre agents d’IA, quel que soit le fournisseur ou l’environnement technique.

Objectif → permettre aux entreprises de déployer des systèmes multi-agents capables de collaborer entre eux de manière fluide, pour automatiser des tâches complexes (recrutement, support IT, logistique…).

Ce protocole est soutenu par plus de 50 acteurs majeurs (Salesforce, SAP, Atlassian ou Capgemini ..) permet aux agents de découvrir les capacités des autres, d’échanger des informations, de gérer des tâches longues ou en temps réel, et de s’adapter à divers formats (texte, audio, vidéo).

En complément du MCP d’Anthropic (voir les précédentes éditions), A2A veut devenir le socle de l’écosystème d’agents collaboratifs. Si la promesse est forte, on peut noter la complexité d'intégration ou la proximité fonctionnelle avec d'autres protocoles existants…

👉 Source : Google Developers Blog

Pour mieux comprendre ce qu’il se passe dans l’environnement des agents IA, je vous invite à lire mes précédentes éditions sur le sujet ici.

Midjourney : un nouveau modèle, plus rapide, plus intelligent et personnalisable

Midjourney lance la version alpha de son nouveau modèle V7, présenté comme le modèle le plus performant. Plusieurs évolutions :

Draft Mode → génération 10x plus rapide et 50 % moins chère, idéale pour itérer rapidement sur des idées. Les images sont en qualité réduite, mais très fidèles pour tester des variantes avant de finaliser.

Une personnalisation activée par défaut → les utilisateurs peuvent activer cette fonction en 5 minutes pour que le modèle s’adapte à leurs préférences visuelles.

Sans oublier une meilleure interprétation des prompts, des textures plus riches, et meilleure cohérence sur les visages, mains, objets et corps…

Ce qu’il faut retenir : Cette nouvelle version marque une montée en puissance pour la génération d’images IA, avec un focus sur l’itération rapide, la personnalisation et la qualité esthétique.

Llama 4 : Meta dévoile sa nouvelle génération de modèles open source multimodaux

Meta présente ses nouveaux modèles Llama 4. La particularité des nouveaux modèles est la fenêtre de contexte (taille des messages envoyés aux modèles) allant jusqu’à 10 millions de tokens (!!) → une référence pour les tâches nécessitant une longue mémoire contextuelle. Llama 4 surpasse le modèle précédent et d’autres modèles (GPT-4o ou Gemini 2.0) sur de nombreux benchmarks.

Je relaie cette information surtout pour vous partager la continuité de l’écosystème Llama face à la concurrence de plus en plus exigeante, mais surtout pour avoir en tête l’extension possible de la fenêtre de contexte.

👉 Source : Meta AI Blog

⚡ 7 Exemples d’utilisations de 4o sur la génération d’images

Le modèle de génération d’images d’OpenAI a surpris tout le monde par la qualité des images générés.

Je tenais à vous présenter 7 cas d’utilisations possibles qui peuvent vous aider côté business. Je suis sûr que certains exemples partagés pourront vous donner des idées.

📝 Le vibe marketing : le no-code du marketing

Lancer une campagne marketing complète en une journée, sans équipe, sans développeur, sans friction ? C’est exactement ce que permet le vibe marketing, une approche radicalement nouvelle du marketing moderne.

Le constat : un marketing traditionnel trop lent

Pendant longtemps, le marketing s’est appuyé sur des process lourds et linéaires. Chaque campagne impliquait :

une coordination entre plusieurs équipes,

une production de contenu manuelle pour chaque canal,

des tests A/B chronophages et coûteux.

Ce modèle est devenu obsolète. Aujourd’hui, il faut aller vite, tester en continu, s’adapter en temps réel.

Un marketing orchestré par l’IA

Le vibe marketing repose sur une combinaison puissante entre des outils capables de générer des interfaces rapides (lovable, replit, bolt, …) et des outils d’orchestrations intelligentes de tâches (agents IA) via Lindy, Gumloop, n8n, ou make dans une moinde mesure.

Les barrières techniques s’abaissent, rendant l’équipe marketing encore plus autonome.

On ne conçoit plus une campagne, on orchestre un système. L’IA prend en charge l’exécution, les tests et les itérations. L’humain se concentre sur la stratégie.

Ce que ça change concrètement

Une seule personne peut désormais lancer des campagnes multicanales, produire des contenus personnalisés, analyser les résultats en continu, itérer en quelques heures, à très faible coût….

Ce modèle donne aux freelances, TPE et petites équipes la capacité de rivaliser avec les agences traditionnelles, avec des cas d'usages du type :

Génération de posts LinkedIn en 1 clic (EasyGen)

Shorts vidéo sans tournage (HeyGen + ElevenLabs)

Articles SEO automatisés (Jasper, Writesonic)

Scraper Reddit qui identifie les tendances et génère des idées de contenus

Agent IA pour gérer les retours clients et les injecter dans Notion

Un changement d’état d’esprit dans le marketing, qui j’espère, pourra vous donner des idées… :)

Merci 🫶🏼

D’avoir lu cette édition jusqu’au bout.

Si ça t’a plu, pense à cliquer sur le ❤️ juste en dessous et partage ton point de vue en commentaire👇🏼

Vous pouvez aussi partager la newsletter à votre entourage (ça me booste beaucoup 🙏) et gagner des cadeaux 🎁

1 parrainage = 1 hack personnalisé

3 parrainages = +400 outils IA triés par thématique et vertical métier

5 parrainages = 30 min de coaching sur votre problématique

À très vite !

Bravo! Encore une newsletter très intéressante d'un bout à l'autre.

C'est étonnant, on entend un morceau de Joe Hisaichi dans la vidéo de Sunday sky. Je ne sais pas s'il y eu une erreur, s'ils ont acheté les droits pour l'exploiter. En tous cas, ça m'amuse d'imaginer une boite qui utilise un avatar (sous entendu, ça diminue les coûts...) et en même temps entendre un morceau qui doit être bien cher à exploiter. Après tout, pourquoi pas, ça pourrait être une stratégie. Au lieu d'avoir le réflexe de vouloir diminuer les coûts partout, on pourrait, avec les outils ia, les répartir autrement. Ouais, je me trouve un peu naïf d'un coup sur le rapport au profit des entreprises.

Merci pour ce contenu toujours aussi qualitatif.