Génération d'images par IA : exemples concrets et conseils

+ 📝 L'IA dans l'éducation

Hello à tous,

Bienvenue dans cette 68ᵉ édition ! Je pensais initialement vous faire un retour sur l'identification et la priorisation de cas d’usage IA mais je me suis dit que je ne pouvais pas manquer de vous partager les nouveaux usages permis par les modèles de génération d'images (comme Nano Banana). Si le 1ᵉʳ sujet vous intéresse, n’hésitez pas à me faire votre retour en commentaire pour que je le programme

On continue de recruter en stage de fin d’études et CDI avec Tandem, vous pouvez consulter l’offre ici. Si ça peut intéresser qqn dans votre entourage, n’hésitez pas à le partager.

Vous pouvez cliquer sur le ❤️ au-dessus ou en fin de newsletter si vous appréciez le contenu, ça m’aide beaucoup ! 🙏

Voici le sommaire de la semaine :

💼 Exemples d’utilisations de l’IA sur la génération d’images

🗞️ 3 actus importantes : Opus 4.5, Mistral 3 et Génération de Vidéo

⚡ Personnaliser chatGPT et automatiser des présentations

📝 L’IA dans l’éducation

⏳ Temps de lecture : 9 min

Me retrouver ailleurs :

🧑💻 Mes réseaux : Linkedin, Youtube

📞 Des besoins en IA : Prendre RDV

💼 Exploiter la génération d’images par IA

Depuis la sortie de Nano Banana pro qui utilise le modèle de raisonnement Gemini 3, on a passé un cap dans la génération des images IA.

Ce cap, il permet d’exploiter l’IA dans la création de contenu et je vais vous partager une série d’exemples concrets. Juste avant, je voulais revenir sur 2 points :

Pourquoi Nano Banana réussit là où les autres modèles échouent ?

Comment simplifier la génération d’images avec un générateur de prompts ?

Pour rappel, si vous souhaitez utiliser Nano Banana Pro, vous pouvez passer par Gemini, puis sélectionner “Create Image” avec le modèle “thinking”.

1/ Pourquoi Nano Banana réussit là où les autres modèles échouent ?

Le problème avec les anciens modèles venait de l’incapacité à respecter les contraintes de notre environnement, structurelles et logiques, autrement dit à raisonner visuellement.

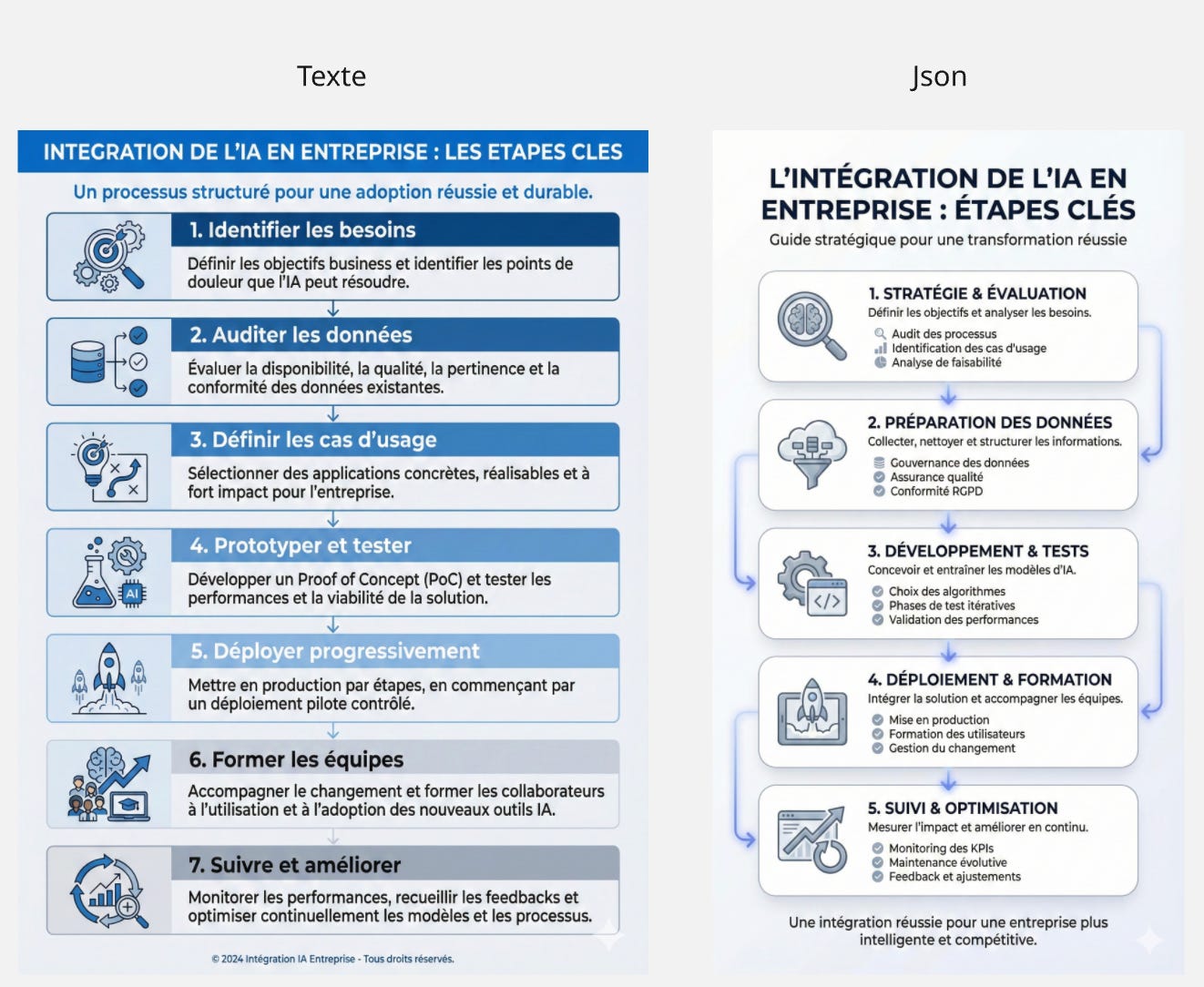

Ici, avec l’utilisation d’un modèle de raisonnement pendant la génération, on contraint la génération d’image pour respecter l’agencement spatial et la relation logique entre les éléments visuels.

Le modèle utilise des logiques de génération différentes en fonction du prompt et réussit à produire des artefacts visuels structurés, sémantiquement cohérents (un peu moins bien en français) et visuellement lisibles.

Comme on va le voir, le modèle est aussi capable de gérer la :

mise en page : des structures spatiales cohérentes (en conservant les grilles / hiérarchies visuelles), ce qui rend l’infographie lisible

typographie : écriture nette, lisible, en petit format avec une mise en forme respectée.

visualisation de données : convertir les chiffres en graphiques / tableau de bord, comme le ferait un tableur ou figma

l’univers de style : cohérence esthétique des éléments, style, palette de couleurs, capable de reconnaitre les éléments de marques (logo) et de les réutiliser.

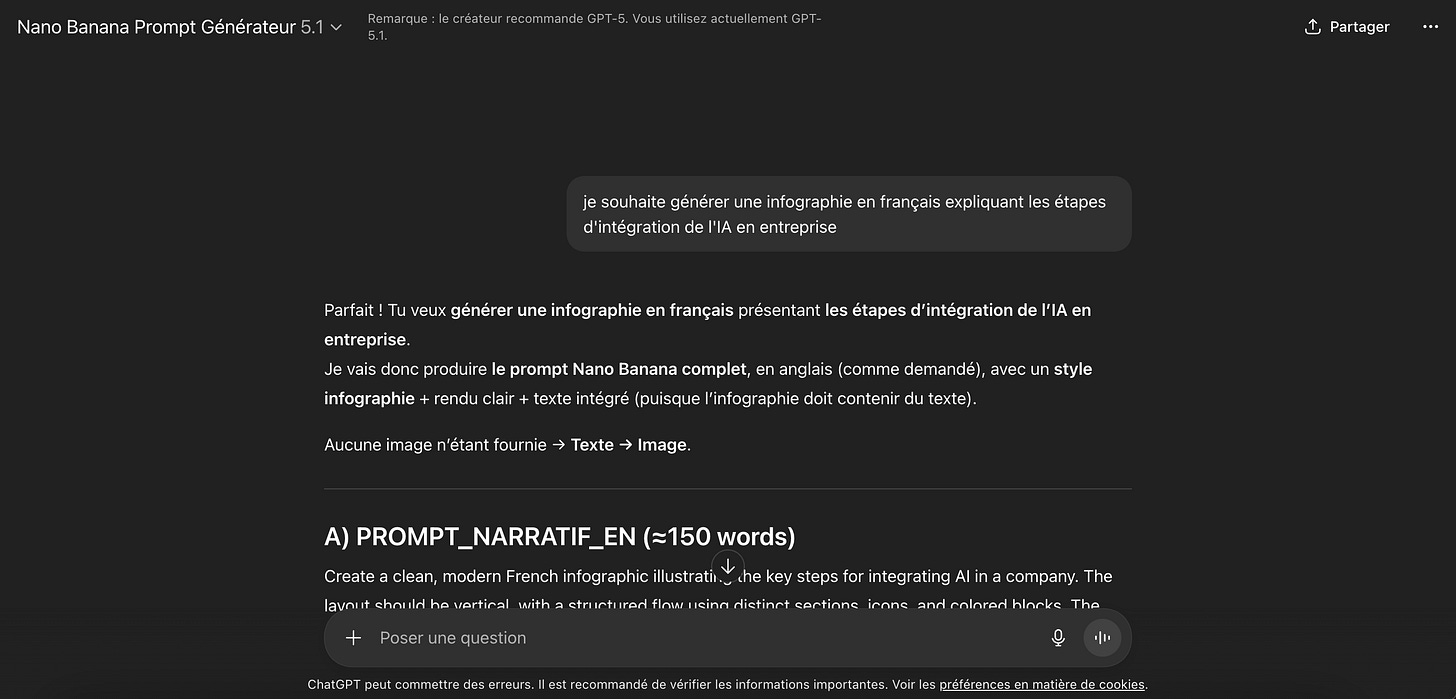

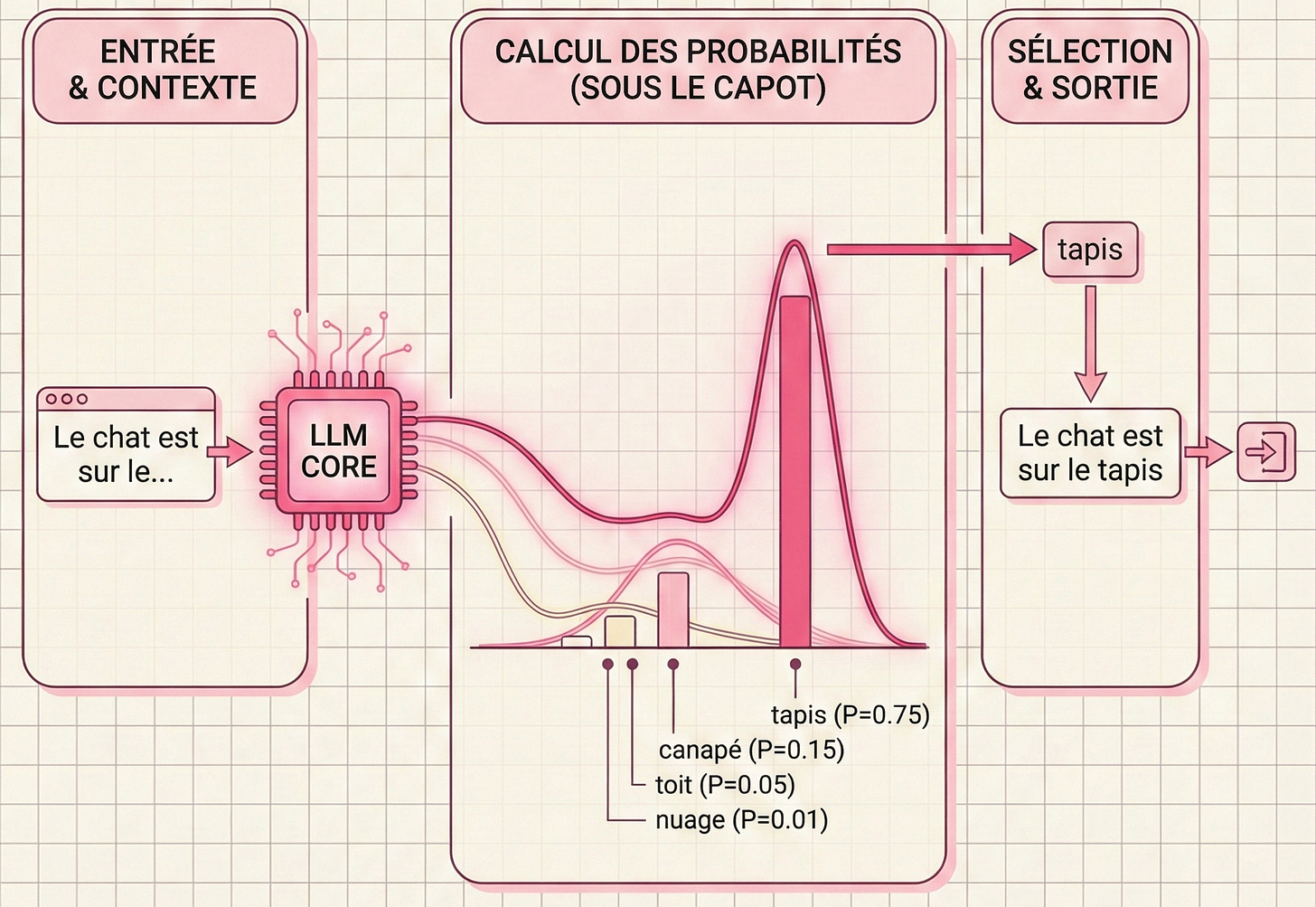

2/ Votre générateur de prompt Nano Banana Pro

Google a précisé que le modèle était beaucoup moins bon lorsque la demande était courte et vague, du type “créer une infographie”, et qu’il fallait plutôt générer des instructions complètes, très précises, comme si on le partageait à un stagiaire expert en design mais qui commence son premier jour.

Mais, pour générer des instructions avancées, autant utiliser l’IA et un assistant qui va élaborer un brief complet. (cet assistant se base sur les recommandations officielles de Google)

Je l’ai créé sur chatGPT, disponible à tous, gratuitement, il vous sort un prompt optimisé en anglais sur un format textuel et un format JSON (plus efficace). Voici le lien de l’assistant :

Par exemple, ici les 2 résultats sur Gemini avec le prompt textuel et JSON :

En général, il est pertinent de structurer votre prompt avec :

le type d’image à générer (tableau de bord, page web, infographie, etc)

l’agencement → comment les éléments doivent être organisés sur l’image

la liste des composants requis

la liste des contraintes à la fin : “le texte doit rester net même en petite taille”, “utiliser un style d’icônes cohérent”

Les nouveaux cas d’usage

Vous avez peut-être remarqué sur LinkedIn une augmentation des infographies, des diagrammes, de tableaux de bord, .. qui sont générés par l’IA. Alors que normalement, il faut compter facilement 100 à 200€ pour une feuille volante complète sur un sujet.

Voici quelques exemples que je partage pour vous montrer le champ des possibles :

Un schéma sur comment un LLM prédit le prochain mot :

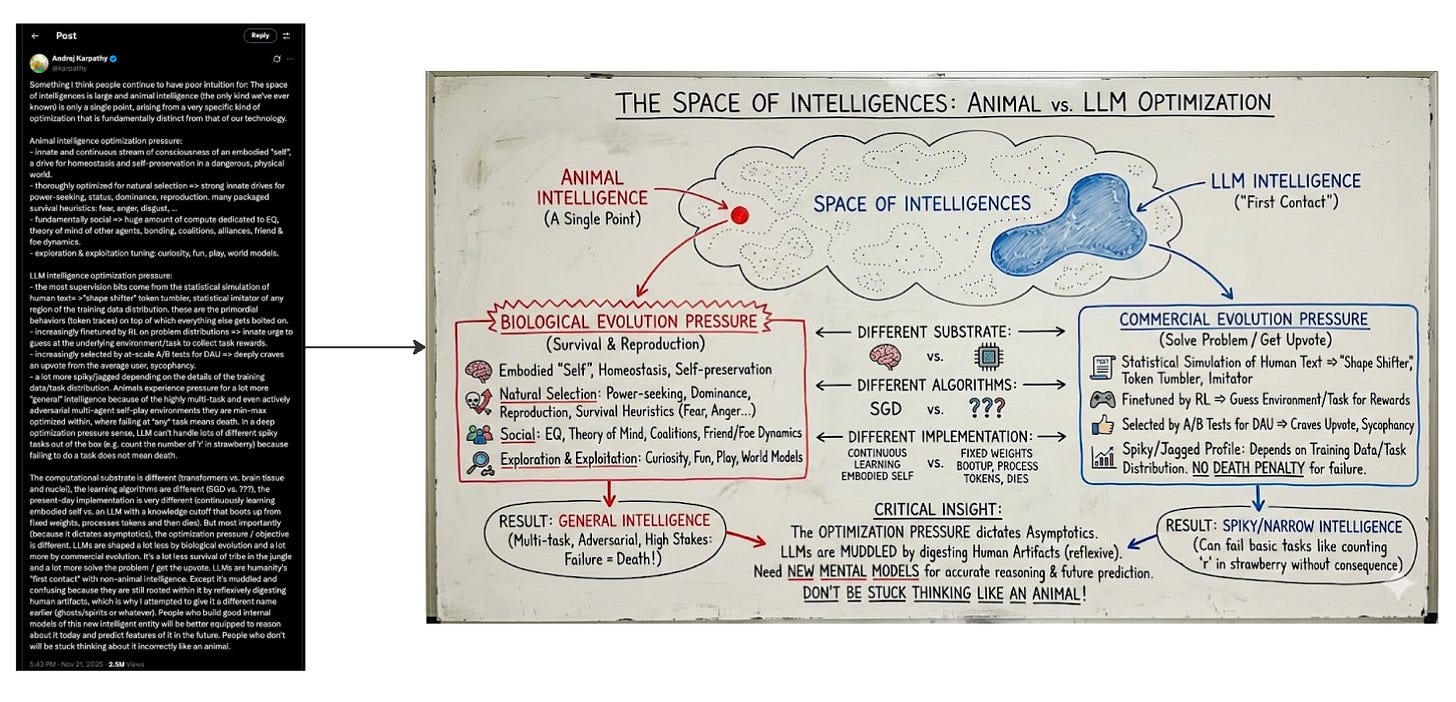

Passer d’un post sur X plutôt complexe à un schéma digne de l’explication d’un professeur sur un tableau (en anglais)

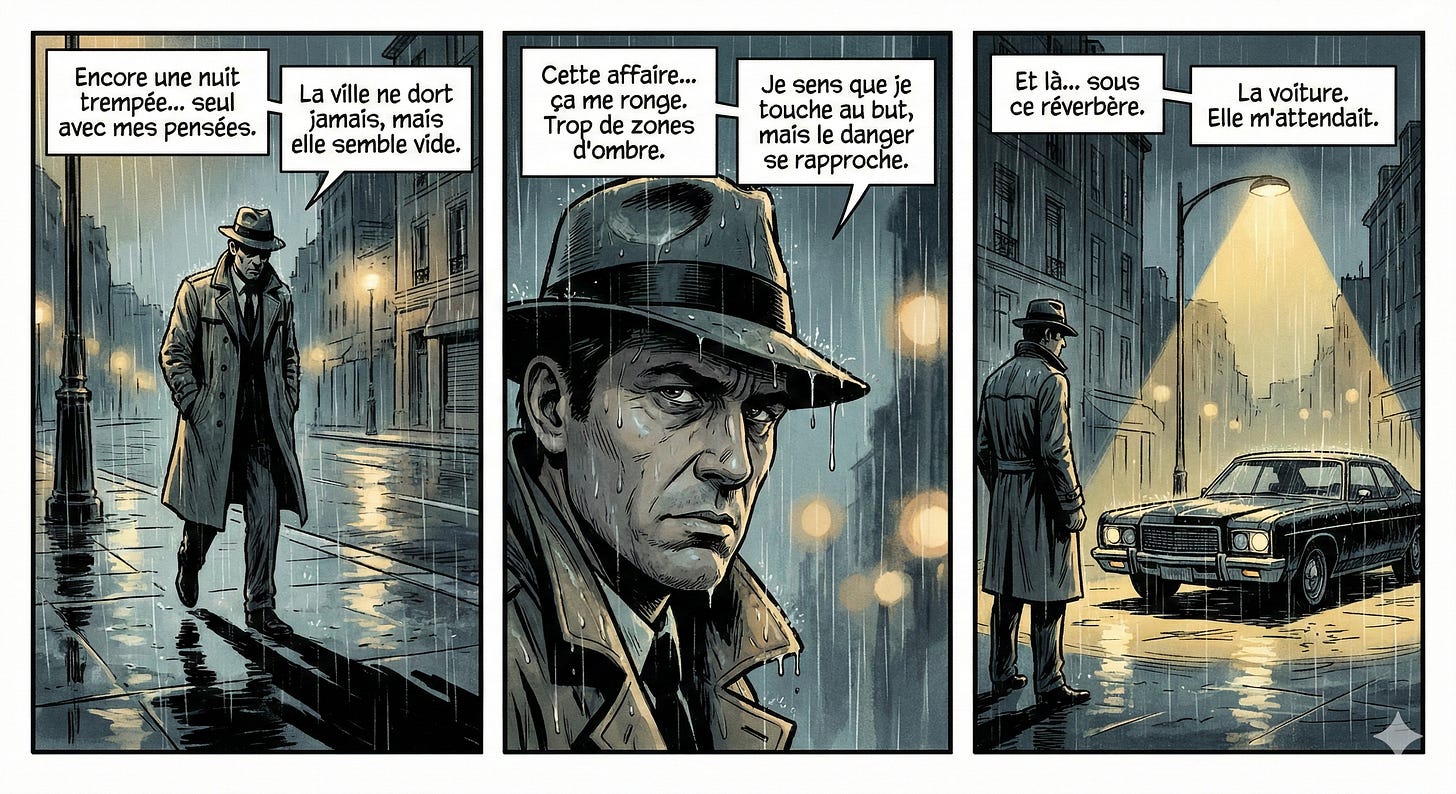

Générer un morceau de BD avec cohérence des scènes (et sans faute)

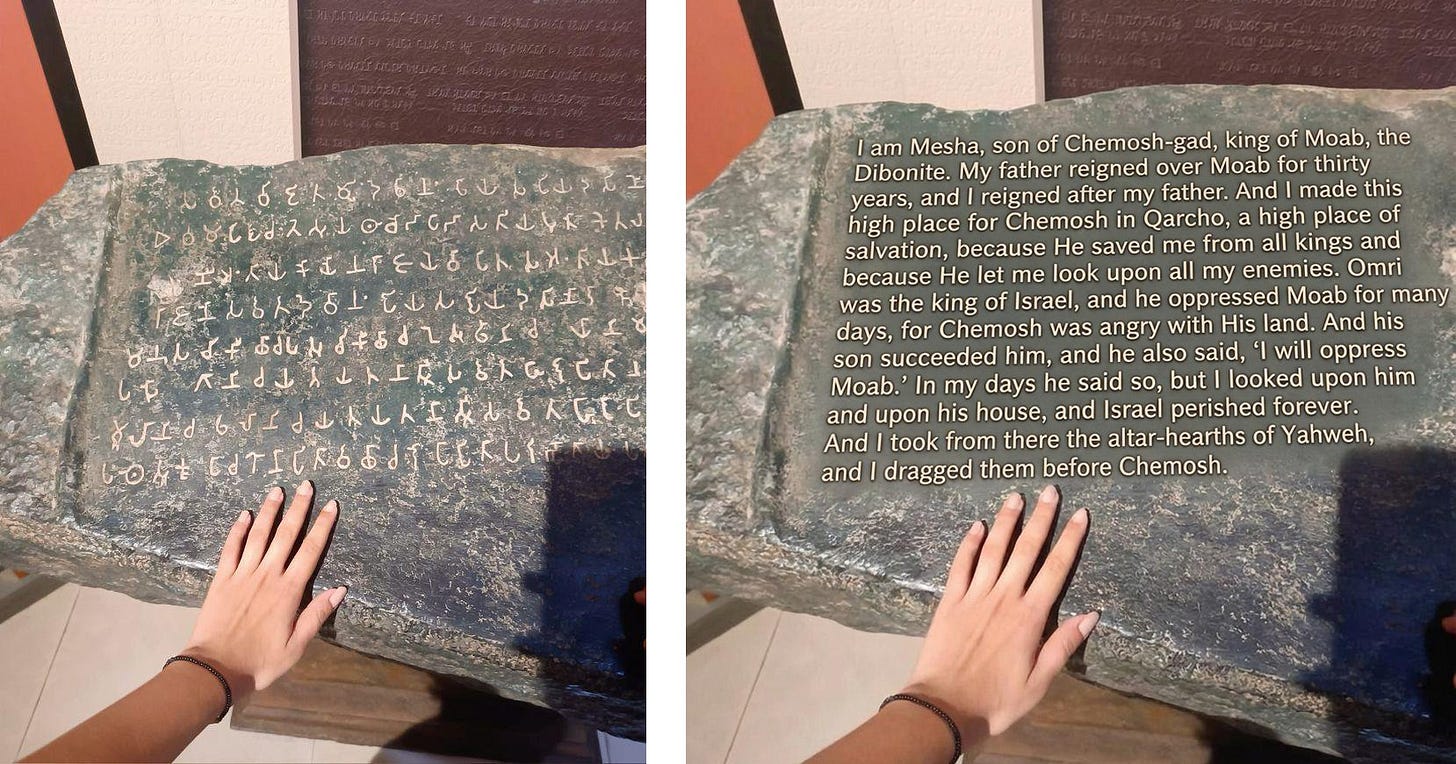

Traduire un contenu directement sur l’image

Transformer une photo floue fournie en une photo ultra-nette et réaliste sans modifier la composition ni les objets.

Créer une image avec les différents éléments qui composent la chaussure de gauche. Disposer les éléments individuellement sur une surface neutre.

Ajouter des yeux globuleux illustrés et coller des mains sur (l’objet/l’animal/votre meilleur ami) dans une pose comique exagérée.

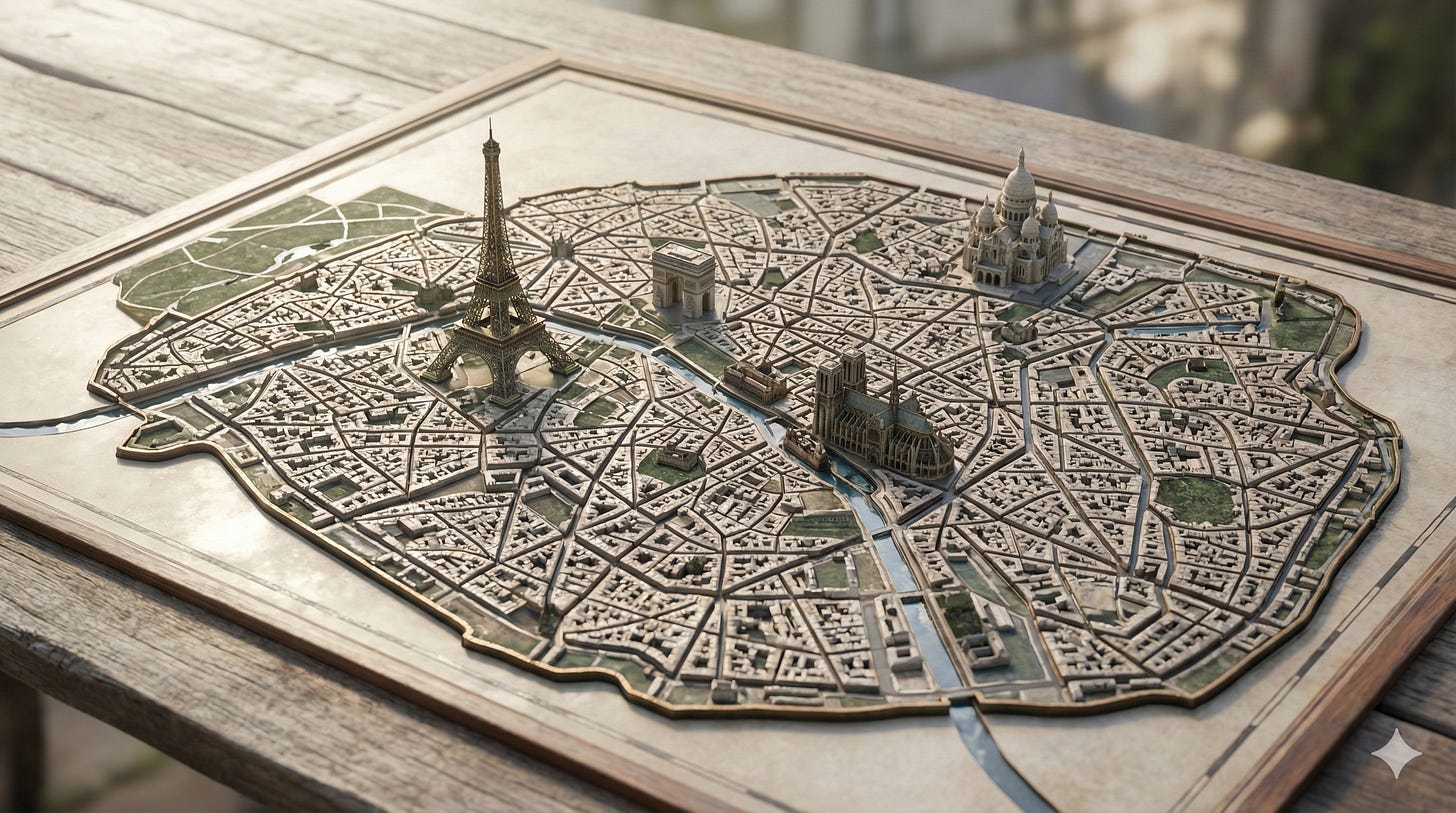

Générer une carte de Paris avec des monuments en 3D

Les possibilités sont super larges sur la partie génération d’images

Les slides via le mode “build” de Gemini

Ici une petite démo sur la génération de slides sur Gemini en partageant simplement une étude. L’utilisation de nano banana est mineure ici mais c’était l’occasion de vous partager ce cas d’usage.

Générer une photo de vous

Dernièrement, j’ai partagé sur LinkedIn comment vous pouvez générer des photos de vous gratuitement.

C’est souvent une galère d’avoir une belle photo, à jour de soi :tenue correcte, lumière approximative, 12 poses forcées qui ne ressemblent à rien… Et au final, une photo “ok”, choisi par défaut.

Maintenant, on a l’IA qui change notre rapport à l’image : on choisit le style en restant derrière notre écran.

Voici comment faire la même chose :

Ouvrir Gemini (pour utiliser nano banana)

Importer une photo de vous (selfie par exemple)

Coller un des prompts

Choisir “Outils” et “Créer des images”, utiliser le modèle “Raisonnement”

Ajuster et itérer

(Conseil : utiliser une photo prise face caméra, avec un fond simple)

🗞️ 3 actus importantes

Anthropic dévoile Claude Opus 4.5 et envisagerait une IPO majeure

Anthropic présente Claude Opus 4.5, son nouveau modèle haut de gamme, pensé comme l’un des plus performants du marché pour le code, les agents autonomes et l’usage avancé de l’ordinateur. Le modèle se distingue par une meilleure compréhension des ambiguïtés, une capacité à résoudre des bugs complexes et des performances nettement supérieures en vision, raisonnement et tâches longues. Opus 4.5 utilise moins de tokens pour des résultats équivalents ou meilleurs, et introduit un paramètre effort permettant aux entreprises d’arbitrer entre rapidité, coût et profondeur d’analyse.

En parallèle, selon le Financial Times, Anthropic envisagerait une IPO dès 2026 et discuterait avec plusieurs grandes banques. L’entreprise explorerait aussi une levée privée pouvant valoriser la société au-delà de 300 milliards de dollars, soutenue notamment par Microsoft et Nvidia. Une telle opération placerait Anthropic en course directe avec OpenAI pour une introduction en bourse, un test majeur pour l’appétit des investisseurs face à des start-up IA à forte consommation de capital.

👉 Source : https://www.anthropic.com/news/claude-opus-4-5

👉 Source : https://www.cnbc.com/2025/12/03/anthropic-claude-reportedly-preparing-ipo-race-openai-chatgpt-ft-wilson-sonsini-goodrich-rosati.html

L’évolution des modèles de génération vidéo IA (avec Runway)

Runway lance Gen-4.5, un nouveau modèle qui redéfinit les standards de la génération vidéo avec une qualité visuelle et une cohérence temporelle inégalées. Déjà leader du secteur avec Gen-4, l’entreprise repousse encore les limites avec cette version qui combine rapidité, fidélité au prompt et contrôle précis sur le rendu final.

Meilleur que Veo 3, ça permet de générer des vidéos réalistes et cinématographiques, tout en conservant les fonctionnalités avancées : image vers vidéo, keyframes, vidéo vers vidéo, etc.

Un exemple du progrès réalisé par Runway sur la vidéo :

Et ici, 3 ans de progrès sur la génération de vidéos IA avec le test des spaghettis :

👉 Source : runwayml.com/research/introducing-runway-gen-4.5

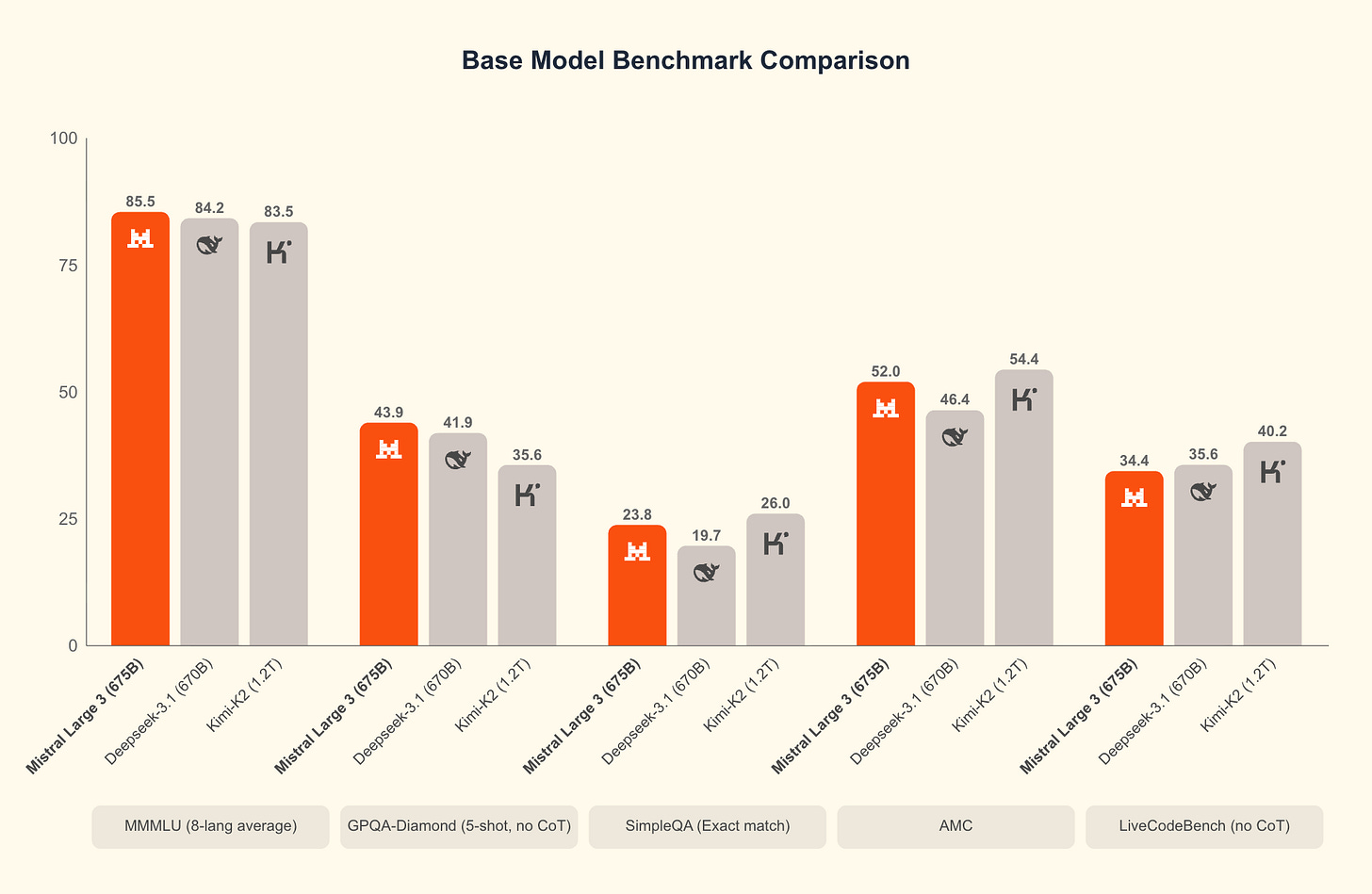

Mistral continue la course au meilleur modèle IA Open Source

Mistral AI dévoile Mistral 3, une nouvelle famille de modèles. Au cœur de l’annonce : Mistral Large 3, un modèle sparse Mixture-of-Experts avec 41B paramètres actifs (675B au total), entraîné avec NVIDIA et désormais l’un des modèles open-weight les plus performants du marché. Il atteint un niveau comparable aux meilleurs modèles d’instruction open-source, avec des capacités multimodales et un fort niveau en conversations multilingues.

En parallèle, les autres modèles offrent un excellent ratio performance/coût pour les déploiements locaux ou embarqués, avec des versions base, instruct et reasoning.

Mistral multiplie par ailleurs les partenariats techniques (NVIDIA, vLLM, Red Hat) pour garantir une optimisation complète, du data center jusqu’aux appareils edge.

👉 Source : https://mistral.ai/news/mistral-3

⚡Astuces pour booster sa productivité

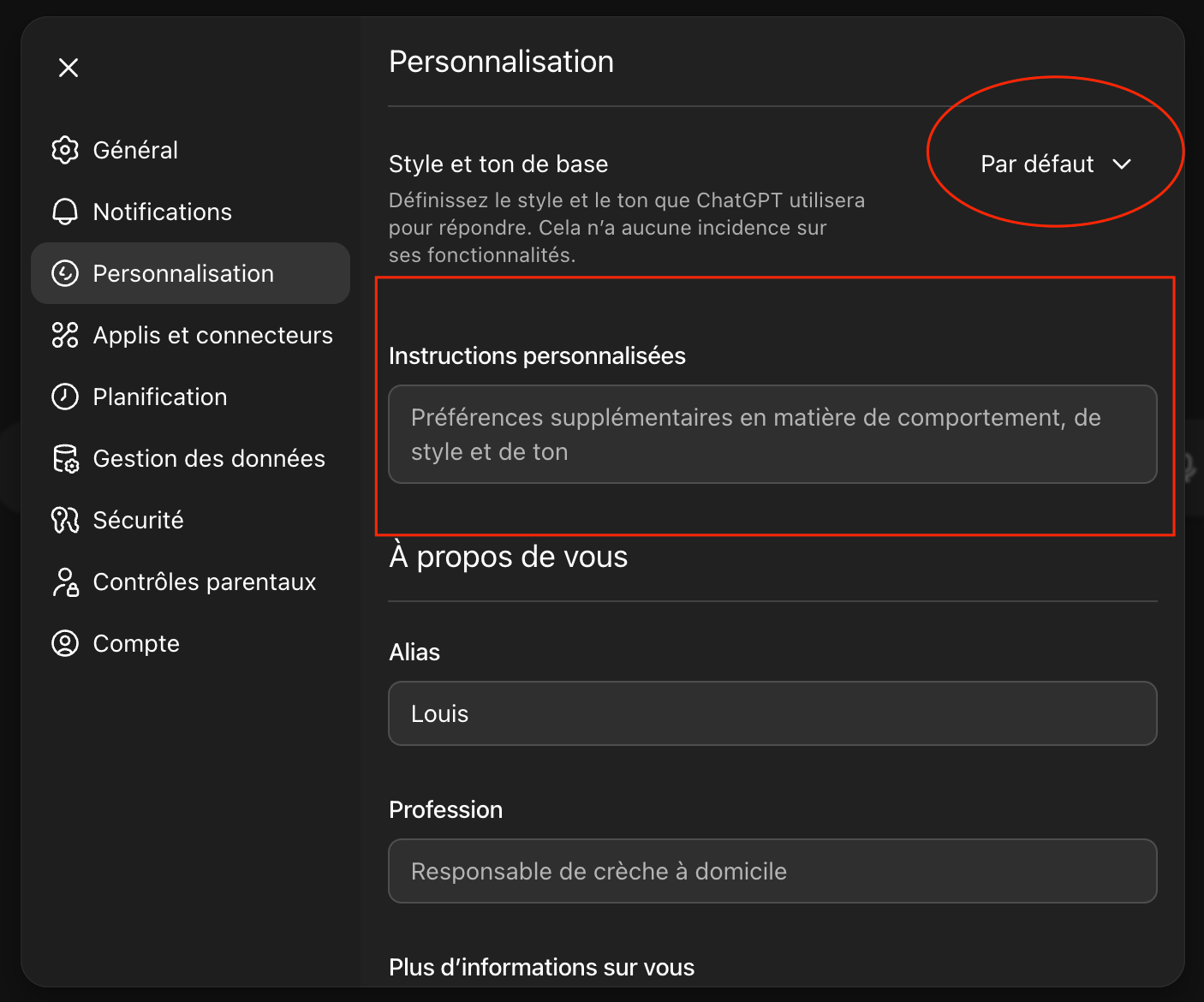

Personnaliser chatGPT

Comment faire pour que chatGPT arrête d’être d’accord avec tout ce que vous dites ?

On peut trouver le modèle un peu trop mielleux alors que l’outil est totalement personnalisable.

Et si vous ne l’activez pas maintenant, vous passez à côté d’un levier massif.

Dernièrement, avec GPT-5.1, tout s’est renforcé : réponses plus précises, style plus cohérent, et surtout… des instructions personnalisées beaucoup plus fiables. (même Sam Altman le dit)

Je vous montre dans cette vidéo un exemple sur 2 questions basiques, et les réponses sont brutalement honnêtes associées, grâce aux instructions personnalisées.

Pour avoir la même chose :

1️⃣ Ouvrir “Personnalisation”

2️⃣ Choisir votre personnalité (Efficace pour la productivité, Cynique pour un style plus tranchant)

3️⃣ Ajouter des instructions personnalisées (le vrai levier)

Tester un prompt, vous verrez immédiatement la différence. Ça permet d’éviter le syndrome où ChatGPT dit oui à tout, avec des — à chaque paragraphe.

Voici le prompt que j’utilise.

Automatiser la création de présentation

J’ai souvent parlé de Gamma pour la création de slides avec l’IA. L’outil propose une API et permet d’automatiser la création d’une présentation en fonction de vos leads entrants.

Je trouve ça super intéressant car on ajoute une couche de personnalisation supplémentaire avec des slides.

Concrètement, le process :

dès qu’on ajoute un lead sur Gsheets (à la fin d’un appel, après le remplissage d’un formulaire, etc)

on génère ensuite une présentation personnalisée en fonction des variables en passant par Claude pour le contenu (le fonds) puis Gamma pour la mise en forme

on envoie le résultat dans une campagne via Instantly ou un autre outil de prise de contact multicanal… L’avantage de ces outils, c’est le suivi automatique avec des relances.

L’API de Gamma est une vraie révolution dans la création, et l’activation commerciale :

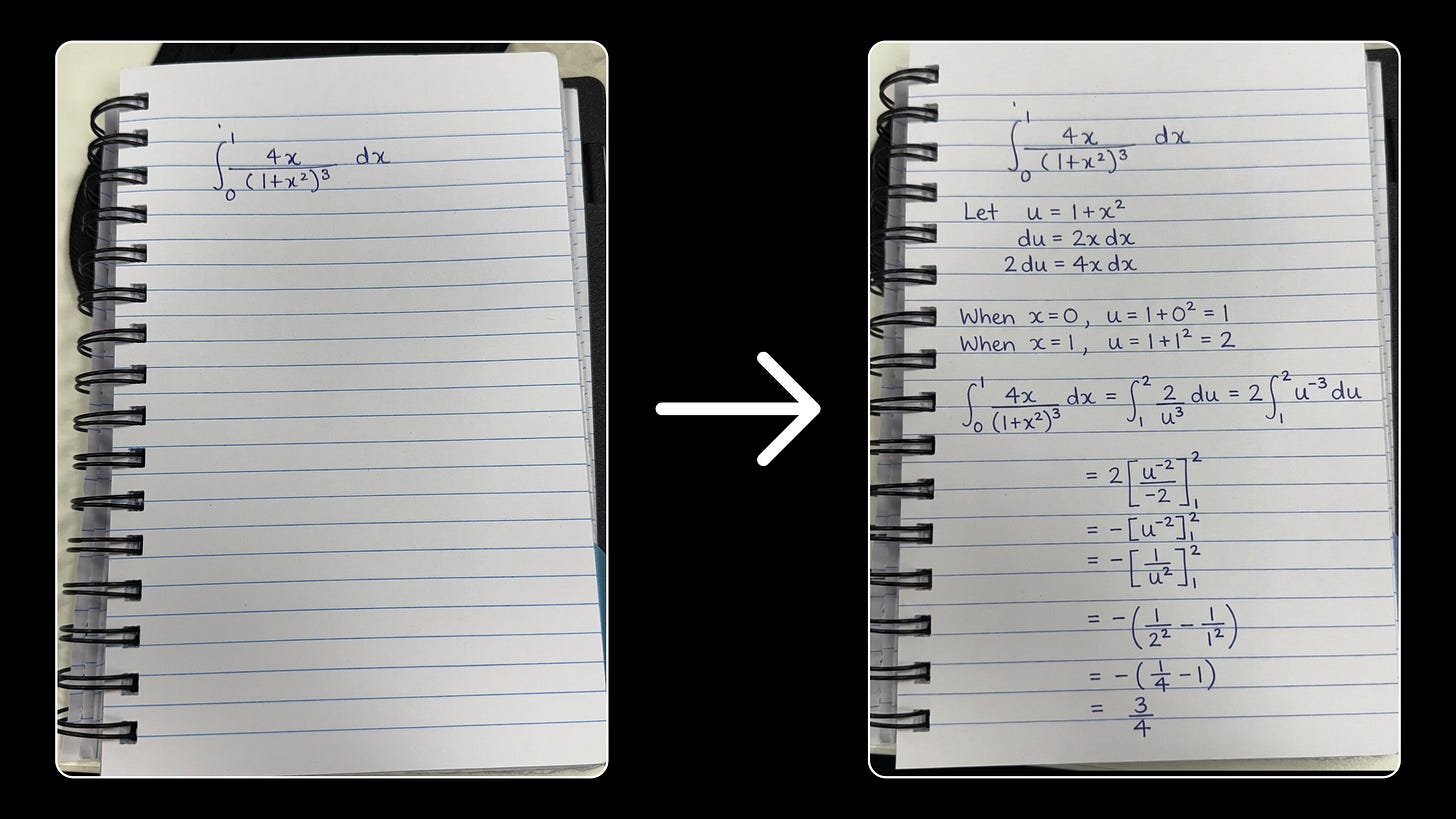

📝 L’IA dans l’éducation

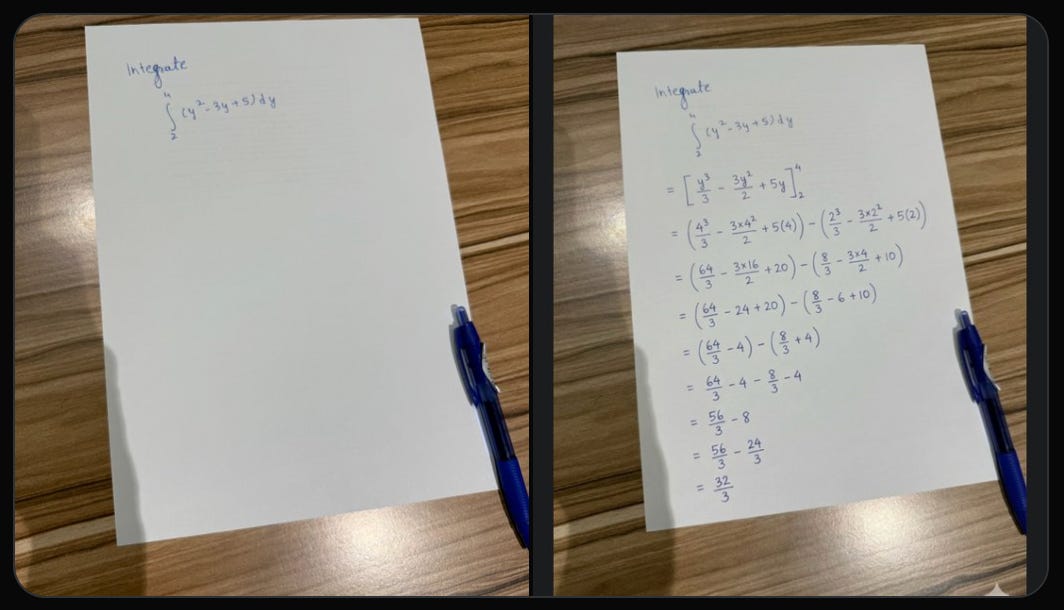

Avec l’évolution de l’IA, j’ai récemment partagé un post sur LinkedIn montrant l’IA capable de résoudre des équations complexes et les remplir directement.

Et c’est aussi possible avec la sortie de nano banana pro. C’est d’ailleurs un peu perturbant car le modèle résout l’exercice directement sur l’image, avec le bon placement, la bonne mise en page, et même un style d’écriture proche de l’original.

Un autre exemple ici :

On ne parle plus de reconnaître une question, et d’y répondre.

On parle de raisonner dans l’espace visuel, comme un humain qui écrit au stylo.

Et forcément, ça doit nous interroger sur le rôle de l’IA dans l’éducation (et son utilisation) Car l’IA ne se limite plus au langage, mais comprend l’environnement, la structure, la spatialité (de plus en plus).

Une occasion de :

1️⃣ Repenser l’évaluation : sortir des exercices reproductibles, aller vers des cas d’analyse, d’oral, de projet.

2️⃣ Assumer l’IA comme outil : comme la calculatrice hier, elle devient une extension du raisonnement.

3️⃣ Former au discernement : vérifier, corriger, challenger les réponses générées.

4️⃣ Concevoir des examens “ouverts” : où l’avantage n’est pas d’avoir l’IA, mais de savoir l’utiliser mieux que les autres.

Il va falloir s’adapter en demandant ce que l’IA a mal compris et corriger son raisonnement.

À ce moment là, on pourra évaluer enfin la pensée critique, pas la capacité à réciter. L’école va devoir évoluer plus vite que prévu…

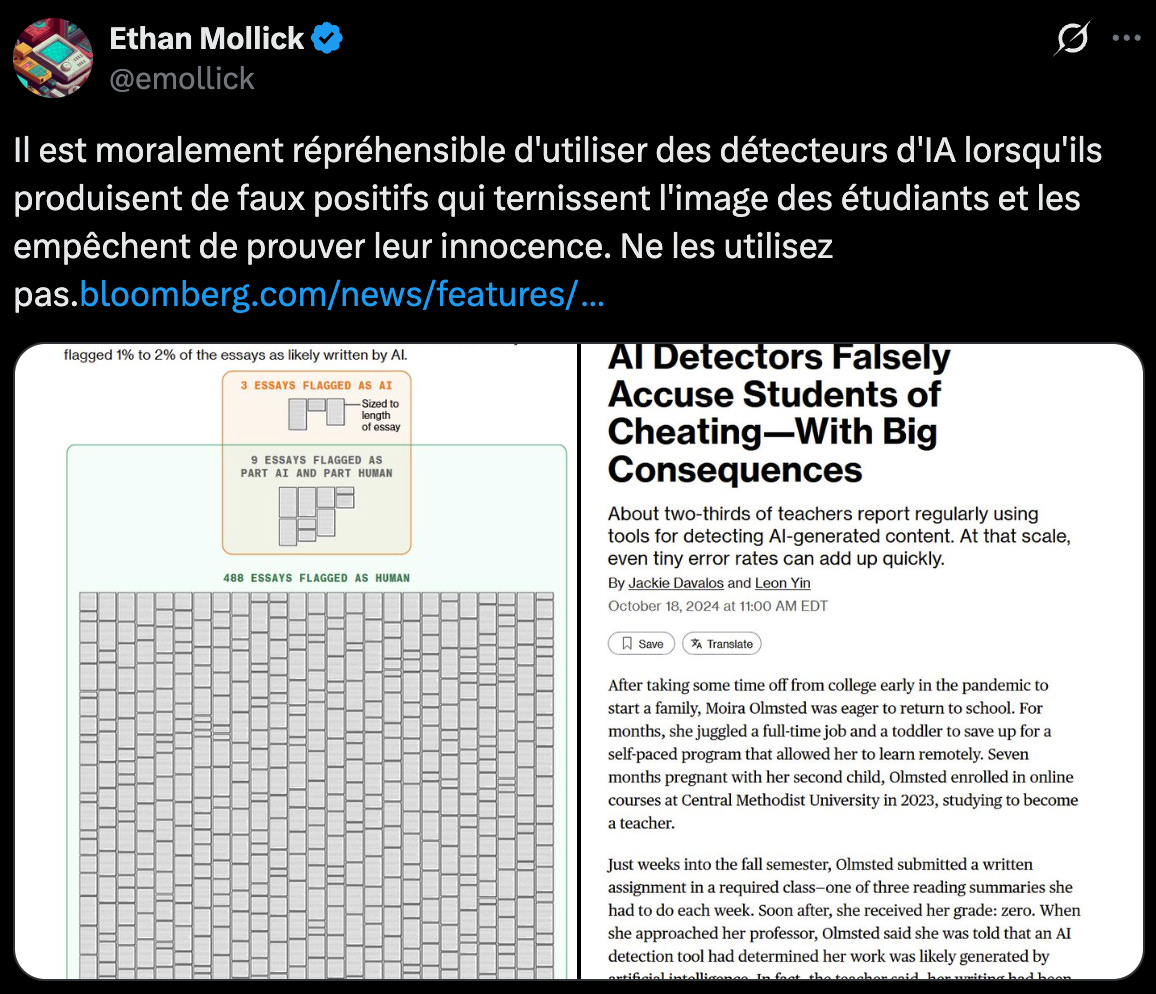

Un autre exemple, c’est l’utilisation d'outils pour détecter si l’IA a été utilisée. Malheureusement, ça ne marche pas et les étudiants ont parfois dû mal à se justifier.

C’est un autre sujet mais je tenais à le partager car beaucoup trop de personnes peuvent utiliser des outils comme zeroGPT.

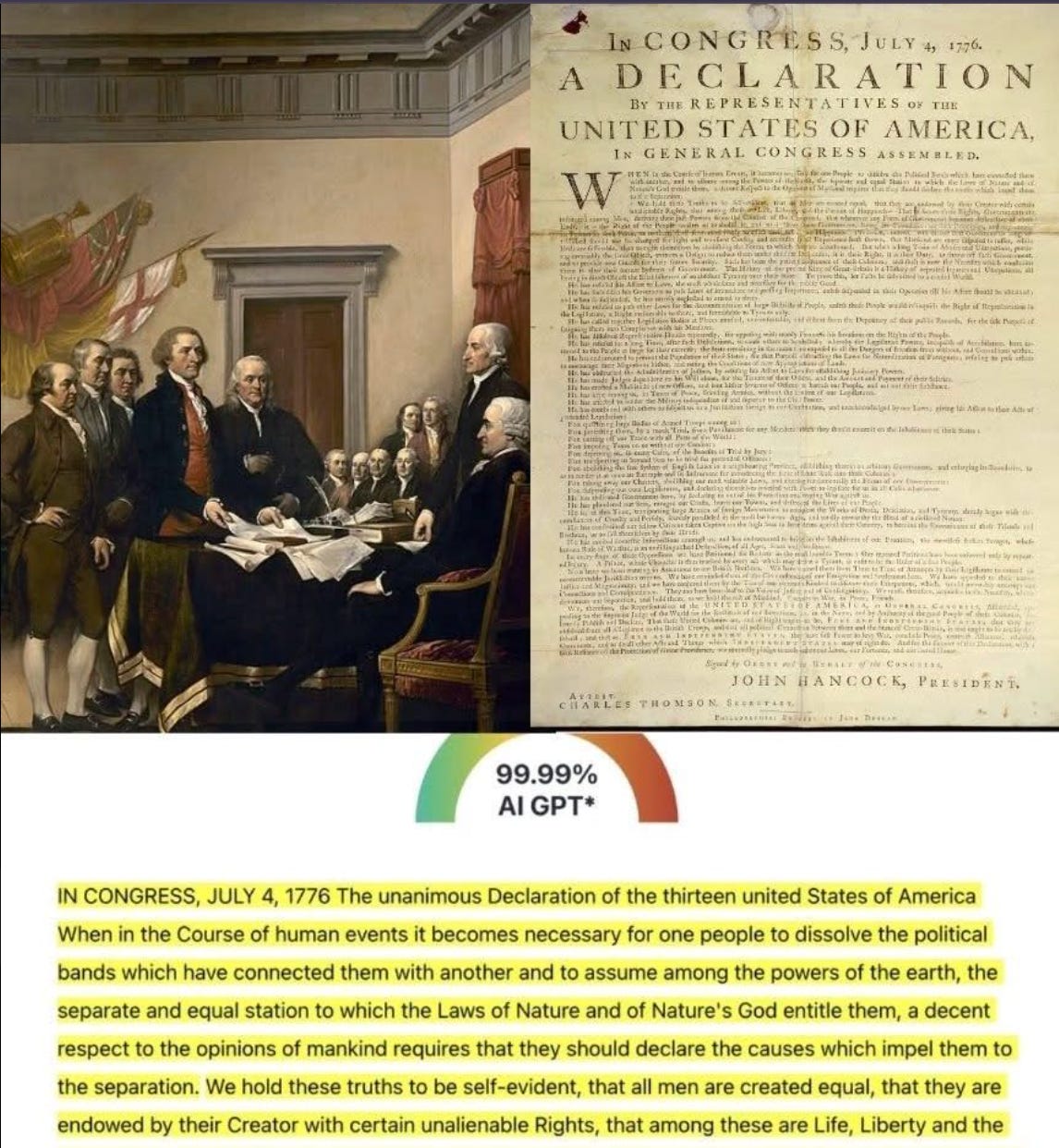

Un exemple ici avec la Constitution américaine jugée “AI-generated”

Merci 🫶🏼

D’avoir lu cette édition jusqu’au bout.

Si ça vous a plu, pensez à cliquer sur le ❤️ juste en dessous et partagez votre point de vue en commentaire👇🏼

Vous pouvez aussi partager la newsletter à votre entourage (ça me booste beaucoup 🙏) et gagner des cadeaux 🎁

1 parrainage = 1 hack personnalisé

3 parrainages = +400 outils IA triés par thématique et vertical métier

5 parrainages = 30 min de coaching sur votre problématique

À très vite !