Cette IA peut naviguer & cliquer sur le web… toute seule. Utile ou gadget ?

+ Prompting & Anthropic Multi-Agents

Hello à tous,

Bienvenue dans cette 57ᵉ édition !

Vous pouvez cliquer sur le ❤️ au-dessus ou en fin de newsletter si vous appréciez le contenu, ainsi que partager cette newsletter à votre entourage ici 🙏

Voici le sommaire de la semaine :

💼 Agent web IA : un intérêt en entreprise ? Zoom sur les cas d’usages

🗞️ 3 actus importantes : Gemini 2.5, Anthropic Multi-Agents, Eleven Labs v3

⚡ Personnalisez un modèle d’IA gratuitement (les Gems de Gemini)

📝 Le prompting sur les modèles de raisonnement

⏳ Temps de lecture : 12 min

Me retrouver ailleurs :

🧑💻 Mes réseaux : Linkedin, Youtube

🤚 Rejoindre la communauté IA (ressources, échange, support, ..) : sur Circle

📞 Des besoins en IA ? Prendre RDV

📖 Se former sur l’IA : exploitez l’IA générative en entrepise ou automatisez votre création de contenu.

💼 Agent Web IA : un intérêt en entreprise ? Zoom sur les cas d’usages

Vous en avez sûrement vu passer : ces agents IA capables de naviguer sur des sites web, cliquer, remplir des formulaires, réserver des billets, tout ça… en totale autonomie.

En ce moment, les solutions explosent : Twin (FR), BrowserBase, H Company (FR), Operator d’OpenAI, Claude Computer Use, etc.

Mais soyons honnêtes, je me suis longtemps demandé si ce n’était pas juste un gadget :

Pourquoi contrôler un navigateur quand une simple API ou un scraping bien fait peut suffire ?

Exemple : je souhaite connaitre les vols disponibles sur Google Flights pour une destination, je pourrais demander à Claude qui a une connexion Google Flights (via MCP)

Pourquoi payer plus cher pour une action qu’un script ou une requête HTTP peut faire 10 fois plus vite ?

Exemple : je souhaite récupérer une information sur un site qui ne dispose pas d’API. Je peux récupérer le contenu html du site pour qu’un modèle d’IA récupère les informations que je cherche.

Pourtant, après avoir creusé les cas d’usage et testé certaines plateformes, il y a des cas concrets où les agents Web IA ouvrent des portes que ni les APIs ni les scripts ne peuvent franchir. Je vous partage mon retour d’expérience.

Une explosion des outils d’agent web

En creusant le sujet, je me suis rendu compte que ce n’était pas juste un effet de mode. Le marché est en explosion, avec des acteurs qui ne jouent pas dans la même cour : certains comme Twin avancent sur des cas d’usage très ciblés comme la récupération de factures pour Qonto.

D'autres comme H Company visent un OS complet de l’automatisation, avec 200M € levés pour y parvenir. (malgré la mise à la porte du CEO)

L’écosystème s’organise autour d’une vraie promesse : rendre l’IA capable d’agir sur le web comme un humain.

Pourquoi ce boom maintenant ?

Trois raisons principales selon moi :

Les modèles ont gagné en capacité de raisonnement, ce qui leur permet de suivre des instructions complexes en plusieurs étapes.

Les modèles multimodaux comme GPT-4V savent désormais “lire” une interface visuelle comme un humain.

Et surtout, les coûts d’inférence ont chuté, rendant ces usages techniquement accessibles, là où ils étaient réservés à la démo il y a encore un an.

Ajoutez à ça des infrastructures comme BrowserBase qui rendent le tout scalable, et on comprend pourquoi l’explosion est aussi brutale que logique.

Un petit aperçu de ce que permet BrowserBase :

Cas d’usage concrets en entreprise

C’est là que j’ai vraiment commencé à comprendre l’intérêt. Les agents WebIA ne sont pas juste là pour “cliquer à notre place”. Ils débloquent des cas qu’on ne pouvait tout simplement pas automatiser avant, ou alors de façon très bancale.

Par exemple sur le cas de Twin : leur agent est capable de se connecter automatiquement à des comptes utilisateurs pour récupérer des factures en ligne :

Soit en exploitant les cookies de session (pour accéder aux interfaces authentifiées sans mot de passe)

soit en affichant une interface intermédiaire où l’utilisateur entre ses identifiants avant que l’agent prenne le relais.

Résultat : plus besoin de dev une intégration API pour chaque fournisseur, ça fonctionne sur n’importe quelle interface web existante, comme le ferait un humain.

Mais les cas d’usage ne s’arrêtent pas là.

Besoin de mettre à jour un catalogue produit sur une marketplace qui change de design toutes les deux semaines ? L’agent s’adapte.

Vous voulez réserver un créneau de transport ou un rendez-vous médical dès qu’il devient disponible, sur un site public sans API ? L’agent peut veiller et agir automatiquement.

En QA, certains agents comme Tester H de H Company peuvent vérifier automatiquement l’affichage, le tunnel de paiement ou la langue d’un site après chaque déploiement, sans maintenir des dizaines de scripts Selenium fragiles.

Ici le remplissage de formulaire sur Skyvern :

Les limites actuelles

Sur certains cas comme l’enrichissement de prospects, je reste très sceptique. Un agent peut parcourir un site ou un profil LinkedIn, lire l’ensemble du contenu, et en générer une synthèse contextuelle enrichie. Mais dans les faits, des outils comme Clay, Apollo ou PhantomBuster font déjà ce travail de manière bien plus rapide, fiable et scalable, grâce à des APIs optimisées.

L’agent web ajoute un degré d’intelligence (il peut analyser la page dans son ensemble, identifier des signaux faibles, croiser des données) Mais à un prix qui ne concurrence pas les solutions en place. Les contraintes de latence, coût par tâche sont bien trop grande. C’est un peu comme prendre un bazooka pour tuer une mouche

Au-delà du coût, les limites techniques sont encore nombreuses.

Le maintien du contexte sur plusieurs pages reste fragile → passer d’une étape à l’autre dans une navigation séquentielle sans perdre le fil est un vrai défi.

La gestion des erreurs (pages qui chargent lentement, Captcha, modaux imprévus…) n’est pas toujours fiable.

Et même si certains agents sont multimodaux, la compréhension visuelle reste imparfaite : un bouton déplacé ou une icône ambiguë peut faire dérailler l'action.

Des outils puissants mais encore instables, coûteux, et souvent très (trop ?) fragiles pour des workflows complexes ou critiques.

Pourquoi (et quand) c’est pertinent

Après avoir exploré ces outils (et déployé browseruse sur 1 cas précis), j’en ressors avec une conviction : les agents web IA peuvent être très utiles côté consumer (ça débloque des situations bien précises), mais dès que l’on a un volume importants de tâches en entreprise, c’est très rarement pertinent.

Voici les cas où potentiellement ça peut l’être :

1er cas : Pas d’API disponible.

C’est probablement le cas le plus évident. Et cela a été mon utilisation dans une boîte d’assurance pour récupérer des attestations depuis une interface et permettre à l’IA de répondre en autonomie au ticket de cette catégorie. Pas d’API, pas de webhook, juste un extranet client. Un agent web permet de s’y connecter et télécharger le document en 1 étape (soit 0,10€ par résolution). Sans ça, c’était une tâche manuelle récurrente pour une équipe support déjà débordée.

2ème cas : Une interface instable ou qui change souvent.

Là, les agents font clairement mieux que les scripts RPA classiques. Je pense notamment à la saisie de données dans un outil interne de gestion des candidatures (type ATS). Jusqu’ici, ça passait par des scripts rigides (type UiPath), mais la moindre modification de l’interface les faisait planter. Un agent web, peut détecter les champs visuellement, adapter son comportement et poursuivre sans qu’on ait à réécrire tout le scénario. C’est bien plus robuste et flexible.

3ème cas : Chaînes d’actions spécifiques, difficilement scriptables.

Un exemple concret : une équipe RH souhaitait préremplir des dossiers sur différents sites partenaires à partir d’un CRM interne. Aucun standard, chaque site a son propre formulaire, ses formats, ses étapes. L’agent peut lire la fiche dans le CRM, comprendre quelle info va où, et remplir les champs au bon endroit sur le site externe. On n’est plus dans une logique “data-in / data-out” comme avec une API, mais dans de l’orchestration intelligente multi-contextes.

Mais il faut rester lucide : ces usages ont un coût. Les tarifs sont différents.

Certains comme Skyvern annoncent 0,10$ par tâche, d’autres comme Operator coûtent 200 $/mois sans API uniquement sur une interface, ou BrowserBase facture à 0,03$ par étape (parfois moins en fonction des modèles)

Sans oublier qu’il faut faire des tests et travailler le prompting : on ne lance pas un agent IA comme un webhook. Il faut décrire ce qu’il doit faire, gérer les cas d’erreur, tester.

Bref, ce n’est pas magique. Mais quand on n’a pas d’API, que les interfaces changent, ou que le besoin implique de la logique métier dispersée sur le web, c’est là que ces agents deviennent vraiment intéressants.

Vers une nouvelle couche d’automatisation

Ce qui est intéressant avec les agents web, c’est que l’on est à l’aube d’une nouvelle couche logicielle, une interface universelle entre les IA et le web. C’est un changement de paradigme majeur : ce ne sont plus les humains qui naviguent sur les interfaces, mais leurs agents.

Dans le fond, ces agents repoussent les limites actuelles : ils savent déjà naviguer, remplir des formulaires, cliquer, interpréter des interfaces complexes, exécuter des tâches en plusieurs étapes.

Demain, ils pourront acheter, réserver, comparer, négocier, et même s’interfacer entre eux dans des logiques agent-to-agent.

Mais tout reste à construire :

Le modèle économique : aujourd’hui, on facture à la tâche ou à l’heure. Mais si un agent commence à exécuter des processus continus, faudra-t-il payer à l’action ? au succès ?

La guerre des plateformes : à mesure que les agents se multiplient, certains sites risquent de bloquer ou filtrer leur accès. On l’a déjà vu avec certains crawlers IA. Et demain, que fera Google, Amazon, ou Meta, quand des agents viendront interagir massivement avec leurs interfaces sans API officielle ? Le rapport de force est encore flou.

L’étape ultime = le paiement autonome. Le jour où un agent pourra, seul, finaliser une commande en ligne ou valider un virement dans un outil de gestion, on basculera dans une nouvelle ère où l’IA n'assiste plus seulement l’humain, mais agit réellement à sa place (interdit en europe pour l’instant)

C’est encore imparfait, souvent coûteux, parfois instable. Mais pour reprendre a16z :

Les agents ne sont pas juste une évolution de l’interface… ce sont des acteurs économiques en puissance.

Et ce n’est que le début.

🗞️ 3 actus importantes

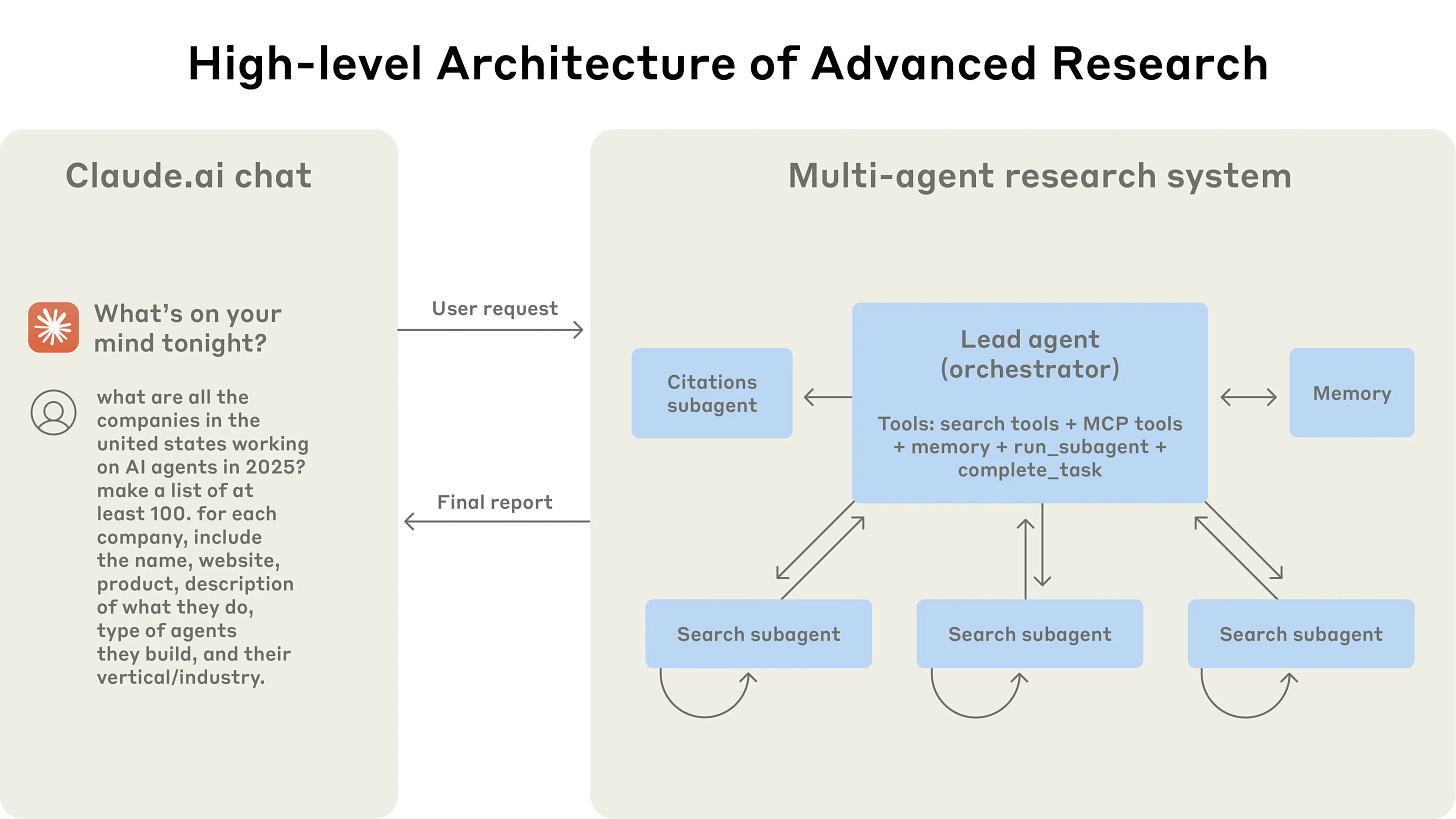

Anthropic dévoile l’architecture de son système de recherche multi-agents

Les solutions de recherche via un modèle (deep research d’OpenAI par exemple) sont super utiles et séduisants. Mais si on soulève le capot, ça donne quoi ?

Anthropic partage les coulisses techniques de sa nouvelle fonctionnalité “Research”, propulsée par une architecture multi-agents. Cette technologie repose sur un agent principal (Claude Opus 4) qui planifie une stratégie de recherche, puis délègue des sous-tâches à plusieurs subagents (Claude Sonnet 4) opérant en parallèle. Chaque subagent explore un angle spécifique d’une requête complexe, permettant une recherche rapide, exhaustive et contextuelle.

Résultat : des performances en nette hausse (jusqu’à +90% par rapport à un agent unique), mais au prix d’une consommation de tokens jusqu’à 15 fois supérieure. Ce système est particulièrement efficace pour les requêtes nécessitant une recherche en largeur, des contextes multiples ou l’utilisation d’outils complexes. Il incarne une avancée majeure pour automatiser des tâches de recherche pro (type stratégie business)

Ce qu’il faut retenir : Claude franchit une étape en combinant coordination d’agents autonomes et prompts sophistiqués. Le futur des assistants IA passera sans doute par ce type d’architecture collaborative.

👉 Source : Anthropic

ElevenLabs dévoile v3 : un nouveau niveau d'expressivité pour la voix synthétique

ElevenLabs vient de lancer Eleven v3 (en alpha), un modèle Text-to-Speech ultra-expressif capable de chuchoter, rire, soupirer ou encore réagir comme une vraie voix humaine. Ce nouveau modèle introduit une expressivité hyper intéressante pour les agents vocaux, grâce à des balises audio comme [excited], [whispers] ou [sighs], et prend en charge plus de 70 langues, ainsi que des dialogues à plusieurs voix.

Bien plus réactif et vivant que les générations précédentes. Par contre, ça demande un peu plus d’ingénierie de prompt. Une version en temps réel est prévue, mais Eleven recommande de rester sur v2.5 Turbo ou Flash pour les cas d’usage conversationnels immédiats.

L’accès à v3 est dès maintenant disponible sur le site d’ElevenLabs. L’API sera accessible publiquement très prochainement.

👉 Source : ElevenLabs

Gemini 2.5 : Google étoffe sa gamme de modèles IA

Google annonce la disponibilité générale de ses modèles Gemini 2.5 Pro et Flash, et dévoile une nouvelle variante : Gemini 2.5 Flash-Lite (en preview). Ce modèle est pensé pour des usages à très haut débit comme la classification ou la synthèse à grande échelle (latence minimale et un coût réduit). Contrairement aux versions Pro et Flash, le "reasoning" y est désactivé par défaut, mais peut être activé via l’API.

Flash-Lite conserve l’accès aux outils natifs de Google (recherche, exécution de code, contexte URL…).

Ce qu'il faut retenir : Gemini propose des modèles spécialisés (avec ou sans raisonnement) en fonction des besoins utilisateurs. Et dans certains cas, des modèles plus rapide et économique, idéale pour les cas d’usage sensibles au coût ou à la latence.

👉 Source : Google Blog

⚡ Personnalisez un modèle d’IA gratuitement

Google permet de créer vos propres assistants IA. Ce n’est pas nouveau, c’est devenu une fonctionnalité indispensable pour exploiter l'IA. GPTs sur OpenAI, Gems sur Gemini, Projects sur Claude, Agents sur Mistral, Spaces sur Perplexity, etc

La particularité de Google : c’est gratuit.

Comme je le montre sur cette vidéo, en 3 minutes et sans compétence technique, vous avez un assistant personnalisé sur votre cas d’usage.

Et ça change la manière de travailler avec l’IA.

J’ai testé en créant un assistant support capable de répondre à partir du centre d’aide d’un site web :

➡️ En 3 minutes, l’assistant est opérationnel

➡️ Il comprend vos contenus internes

➡️ Il peut être partagé à une équipe sans compétences techniques

Pour tester :

1️⃣ Rendez-vous sur gemini.google.com

2️⃣ Cliquez sur “Gem Manager” → “New Gem”

3️⃣ Rédigez vos instructions et ajoutez vos documents

En bref :

Vous définissez les instructions

Vous ajoutez des fichiers ou une base de connaissances

Vous testez et exploitez l’assistant sur votre compte.

Et c’est souvent l’étape numéro 1 avant un déploiement plus ambitieux.

Pour basculer sur un assistant API ou d’en faire un agent autonome,

Cette phase permet d’itérer rapidement, affiner les instructions, valider les cas d’usage, le tout sans compétence technique.

Une fois stabilisé, cet assistant peut ensuite être intégré dans un workflow automatisé par un appel API simple ou transformé en agent IA connecté à vos systèmes, accessible côté client ou prospect.

Créer un assistant IA devient aussi simple que remplir un formulaire.

Et c’est le moyen le plus rapide pour faire passer l’IA du concept à l’usage.

J’avais aussi fait un tutoriel sur les GPTs sur ce lien vidéo.

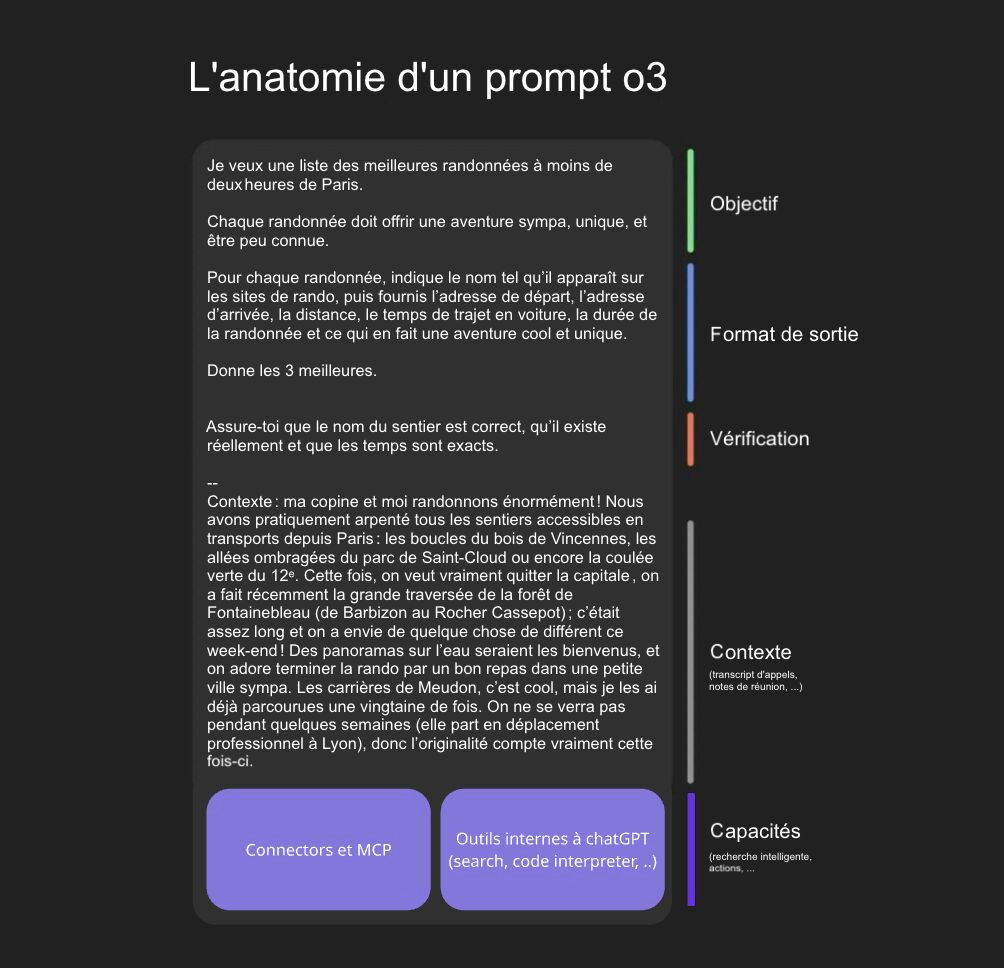

📝 Le prompting sur les modèles de raisonnement

Les modèles de raisonnement sont de plus en plus présents, mais la manière de les utiliser (de prompter) est souvent différente de ce que l’on a l’habitude de faire avec les modèles plus classiques.

Avec la sortie du dernier modèle o3 d’OpenAI (voir plus haut), j’en profite pour vous partager le format idéal pour prompter ces nouveaux modèles.

L’idée est d’avoir une structure où :

On leur donne un objectif.

On leur structure le format de réponse.

On les alerte sur les erreurs possibles.

Et on leur fournit du contexte réel : des appels API (connecteurs à Google Drive, HubSpot, fichiers, ..)

Ils ne devinent plus (ou interprète).

Ils raisonnent sur des données métier.

D’ailleurs, ces modèles deviennent moins cher, plus rapide, plus précis et leur usage va donc s’étendre.

→ Le coût de l’intelligence tend vers celui de l’électricité.

Quand o3 est arrivé, OpenAI a baissé le prix de 80 % en quelques jours.

Le coût unitaire devient quasi négligeable.

Les modèles ne sont plus seulement des assistants conversationnels.

Avec des capacités en raisonnement, ils sont des cerveaux d’exécution.

Contextualisés. Outillés. Connectés.

J’en parlais aussi à la fin de cette édition si vous souhaitez continuer de creuser le sujet

Merci 🫶🏼

D’avoir lu cette édition jusqu’au bout.

Si ça vous a plu, pensez à cliquer sur le ❤️ juste en dessous et partagez votre point de vue en commentaire👇🏼

Vous pouvez aussi partager la newsletter à votre entourage (ça me booste beaucoup 🙏) et gagner des cadeaux 🎁

1 parrainage = 1 hack personnalisé

3 parrainages = +400 outils IA triés par thématique et vertical métier

5 parrainages = 30 min de coaching sur votre problématique

À très vite !

Excellent ! Merci et bravo!